神经网络中的每个节点接受输入值,并将输入值传递给下一层,输入节点会将输入属性值直接传递给下一层(隐藏层或输出层)。在神经网络中,隐层和输出层节点的输入和输出之间具有函数关系,这个函数称为激励函数(激活函数)。

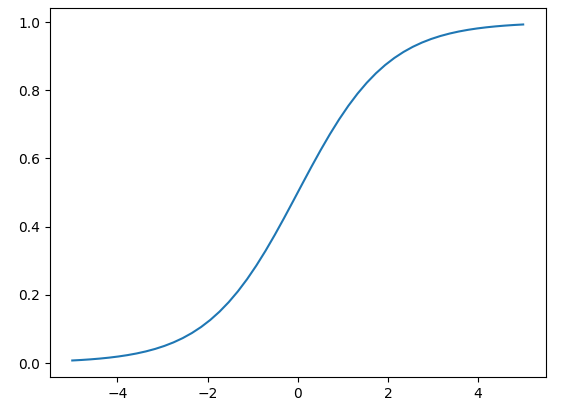

1、Sigmoid函数

%matplotlib inline

import numpy as np

import matplotlib.pylab as plt

def sigmoid_function(x):

return 1/(1 + np.exp(-x))

x = np.linspace(-5, 5)

y = sigmoid_function(x)

plt.plot(x, y)

plt.show()

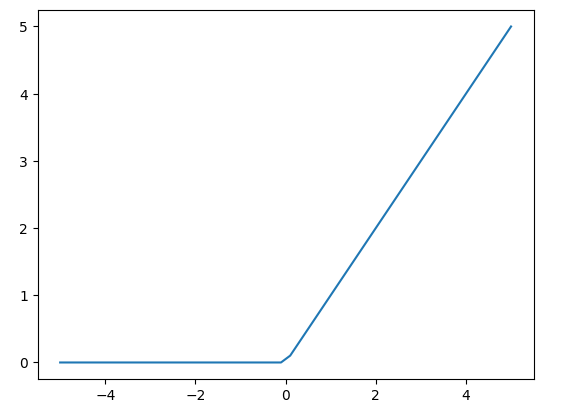

2、ReLU

%matplotlib inline

import numpy as np

import matplotlib.pylab as plt

def relu_function(x):

return np.where(x <= 0, 0, x)

x = np.linspace(-5, 5)

y = relu_function(x)

plt.plot(x, y)

plt.show()

3、SoftMax函数

import numpy as np

def softmax_function(x):

#print(np.exp(x))

return np.exp(x)/np.sum(np.exp(x)) # SoftMax函数

y = softmax_function(np.array([1,2,3]))

print(y)

[0.09003057 0.24472847 0.66524096]